Detektory AI – czy naprawdę działają? „Wskaźnik ryzyka, a nie wyrocznia”

Wraz z upowszechnianiem się narzędzi wspomaganych AI do generowania treści, na popularności zyskują tzw. detektory AI, pokazujące czy dany materiał stworzył człowiek czy maszyna. Jak dalece są jednak skuteczne i czy można je oszukać? W dyskusji o ich rzeczywistej wartości warto spojrzeć szerzej niż tylko poprzez pryzmat technologii – w szczególności uwzględniając cele i wyzwania w obszarach społecznych, edukacyjnych czy biznesowych – uważa Leszek Ortyński, dyrektor, lider ds. AI i data science w KPMG w Polsce.

Ilość treści w internecie wygenerowanych przez sztuczną inteligencję będzie tylko rosła – uważają naukowcy z Uniwersytetów w Cambridge i Oksfordzie. Jesienią ubiegłego roku opublikowali badanie, z którego wynika, że w 2024 roku nawet 57 proc. tekstów dostępnych online powstało przy użyciu algorytmów AI. Do końca tego roku odsetek ten może wzrosnąć nawet do 90 proc.

Jeśli trend się utrzyma, to kolejnym modelom AI będzie trudniej o dostęp do tekstów, grafik i wideo stworzonych przez ludzi. A to może przyspieszyć proces tzw. „kolapsu modeli” – AI uczone na AI straci swoją funkcjonalność, bo będzie oderwane od rzeczywistości. W efekcie, stanie się dla użytkowników bezużyteczny lub użyteczny w ograniczonym zakresie.

Z dzisiejszą wiedzą trudno ocenić, w jakim stopniu powyższy scenariusz się spełni. Jedno wiemy - po narzędzia AI sięgamy już coraz częściej – do nauki, pracy, rozrywki. To nie równa się jednak całkowitemu zachłyśnięciu narzędziami AI. O tym, jak rozpoznawać teksty pisane „ręką sztucznej inteligencji”, radziliśmy kilka tygodni temu na naszych łamach. Dziś chcemy opowiedzieć o „wykrywaczach” treści tworzonych w generatorach typu ChatGPT. Mowa o detektorach AI.

Zobacz: Polski serwis o AI stworzony przez AI. „Nie chcemy straszyć”

Detektory AI – jak to działa

Detektory treści AI to narzędzia analizujące tekst, aby określić, czy został stworzony przez człowieka, czy wygenerowany przez sztuczną inteligencję. Ich działanie opiera się na algorytmach uczenia maszynowego (machine learning) oraz przetwarzania języka naturalnego, które uczą się na gigantycznych zbiorach tekstów pochodzących z obu tych źródeł.

Główne wskaźniki stosowane przez te detektory to tzw. perplexity (stopień zaskoczenia) oraz burstiness (zmienność stylu).

Ten pierwszy ocenia, jak przewidywalny jest tekst, drugi – mierzy stopień jego różnorodności. Teksty napisane przez człowieka są bardziej zróżnicowane, nieszablonowe, z ciekawymi porównaniami i puentami, czasem pomieszanym szykiem.

W praktyce działa to tak, że użytkownik wkleja fragment tekstu do narzędzia, które następnie analizuje w nim wzorce językowe, poziom złożoności zdań oraz częstotliwość i kolejność użytych słów. Otrzymane dane porównywane są z bazą tekstów ludzkich i AI, a narzędzie podaje ocenę prawdopodobieństwa źródła tekstu w formie procentowej lub opisowej. W niektórych przypadkach detektory wskazują też konkretne fragmenty, które uznaje za „AI-owe”.

Zobacz: Tak streszczenia AI w Google zabierają ruch wydawcom. Liczby mówią wiele

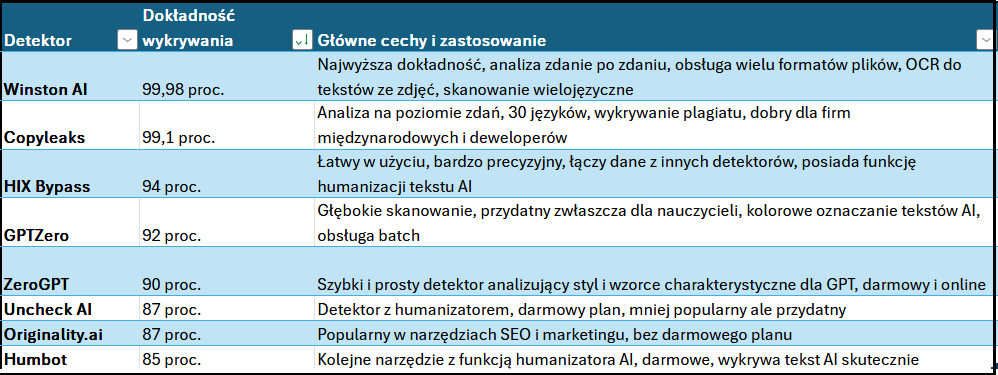

Na potrzeby tego tekstu o najpopularniejsze detektory AI zapytaliśmy… samą AI. Jedna z popularniejszych wyszukiwarek zasilanych sztuczną inteligencją podała nam taką listę:

– Narzędzia do wykrywania treści generowanych przez AI, takie jak GPTZero, Originality.ai czy Turnitin AI Detector, są ciekawe, ale wciąż niedoskonałe. Ich skuteczność mocno spada przy krótszych tekstach, a nowoczesne modele językowe, trenowane do „brzmienia bardziej naturalnego”, potrafią je stosunkowo łatwo obejść. W praktyce oznacza to ryzyko fałszywie pozytywnych lub negatywnych wyników – ocenia w rozmowie z Wirtualnemedia.pl Patryk Pijanowski, członek AI Chamber i CEO Mysite.ai.

Detektory AI – nie tylko technologia

Leszek Ortyński, dyrektor, lider ds. AI i data science w KPMG w Polsce: – Detektory sztucznej inteligencji (SI) zyskują na popularności wraz z upowszechnieniem się modeli genAI. W dyskusji o ich rzeczywistej wartości warto spojrzeć szerzej niż tylko poprzez pryzmat technologii – w szczególności uwzględniając cele i wyzwania w obszarach społecznych, edukacyjnych czy biznesowych.

Jako przykład, nasz rozmówca podaje kampanie dezinformacyjne. – GenAI stworzył nowe możliwości dla twórców takich kampanii poprzez masowe i szybkie generowanie treści. Wdrożenie detektorów SI może pomóc spowolnić i istotnie ograniczyć szerzenie się kampanii dezinformacji, poprzez inne traktowanie w algorytmach sieci społecznościowych treści stworzonej przez SI, a inaczej przez człowieka – uważa ekspert KPMG.

W ocenie Leszka Ortyńskiego same detektory SI mogą zacząć przynosić więcej szkód niż pożytku, jeśli przestaną spełniać dobrze swoją podstawową funkcję i zaczną kwalifikować jako wytworzone przez SI treści stworzone przez człowieka. – W takich sytuacjach, zamiast wspierać procesy weryfikacji treści, stają się przeszkodą – obciążając zarówno twórców rzetelnych materiałów, jak i organizacje, które z tych materiałów korzystają – prognozuje ekspert.

Zobacz: OpenAI zapłaci 30 mld dolarów za usługę, która jest pożeraczem prądu

„Wskaźnik ryzyka, nie wyrocznia”

– Detektory AI wyszły z fazy eksperymentu i stały się pełnoprawnymi narzędziami dla firm, uczelni oraz wydawców. Coraz więcej organizacji traktuje je nie jako ciekawostkę, lecz jako obowiązkowy element procesu weryfikacji treści, podobnie jak moduły antyplagiatowe – wskazuje Joanna Szklarczyk, content marketing manager w Harbingers, agencji e-commerce marketingu.

Dalej specjalistka opowiada nam o testach detektorów AI przeprowadzonych przez Harbingers. Agencja zbadała skuteczność kilku popularnych detektorów, takich jak ZeroGPT, GPTZero, Smodin, isgen.ai i Originality AI.

– Ten sam tekst wygenerowany przez AI, w narzędziu Smodin został oceniony jako w większości (75 proc. ) napisany przez człowieka, podczas gdy isgen.ai wykrył sztuczną inteligencję w 78 proc. treści. GPTZero dawało skrajne wyniki w zależności od tekstu, a Originality AI wypadło w naszych próbach najbardziej spójnie, choć wyniki również nie zawsze były doskonałe. Detektorom zdarzało się również oceniać treść jako w większości napisaną przez AI, chociaż analizie poddawany był tekst w całości stworzony przez człowieka. Żadnego z testowanych narzędzi nie mogliśmy ocenić jako niezawodnego, a nasze testy pokazały, jak różnie mogą być interpretowane te same treści. Dla nas jest to jasny sygnał, żeby traktować te wyniki jako wskazówkę, a nie jednoznaczny dowód.

Dlatego Joanna Szklarczyk radzi: – Należy stosować podwójną weryfikację treści i zwracać uwagę na długość tekstu. Dla fragmentów krótszych niż 200 słów skuteczność wszystkich narzędzi gwałtownie spada.

Warto będzie śledzić rozwój detektorów AI w kontekście nadchodzących zmian prawnych. Dostawcy tego typu narzędzi będą musieli przygotować się na rok 2026 – wtedy to unijny AI Act nałoży na dostawców dużych modeli językowych obowiązek implementacji mechanizmów pozwalających automatycznie identyfikować wygenerowane treści.

Newsletter

Newsletter

Sales&More i Bank Pekao S.A. wkraczają do gry! Sukces kampanii „Jak nie teraz, to kiedy… wbijesz na wyższy level?”

Sales&More i Bank Pekao S.A. wkraczają do gry! Sukces kampanii „Jak nie teraz, to kiedy… wbijesz na wyższy level?”  Serwisy społecznościowe, których już nie ma. Czego nas nauczyły?

Serwisy społecznościowe, których już nie ma. Czego nas nauczyły?  Będzie wielki powrót do „Szkła kontaktowego”?

Będzie wielki powrót do „Szkła kontaktowego”?  Filip Chajzer ponownie w „Dzień Dobry TVN”. Kolejne powroty na jubileusz programu

Filip Chajzer ponownie w „Dzień Dobry TVN”. Kolejne powroty na jubileusz programu

Dołącz do dyskusji: Detektory AI – czy naprawdę działają? „Wskaźnik ryzyka, a nie wyrocznia”