“Humanity's Last Exam”: test, który decyduje czyja AI jest najlepsza

Wyścig o najlepsze aplikacje i asystentów AI w pełni. Jednym z ważniejszych wskaźników, który pokazuje kto jest w nim liderem jest test “Humanity's Last Exam” (Ostatni egzamin ludzkości). Czym jest i kto stworzył test, którego wyniki mają obecnie olbrzymie znaczenie dla pozycji takich firm jak OpenAI, Meta, Google czy xAI?

Ciężko znaleźć wymierne i sprawiedliwe wskaźniki dla takich dziedzin jak na przykład kreatywność czy osądzić czyje dzieła artystyczne są lepsze. Ten problem jest zdecydowanie mniejszy w przypadku sztucznej inteligencji. Istnieje kilkanaście różnych testów, które dają jasną odpowiedź, które AI jest lepsze. Jednym z najbardziej rozpoznawalnych jest “Humanity's Last Exam”. Każdy nowy model AI w momencie ogłoszenia wejścia na rynek podaje również procentowy wynik, który otrzymał właśnie w tym teście jako potwierdzenie swojej jakości.

Kto stworzył “Humanity's Last Exam”?

Idea testu powstała w głowie Dana Hendrycksa, dyrektora organizacji Center for AI Safety (CAIS). Zrodziła się podczas rozmowy z Elonem Muskiem, który podobno stwierdził, że istniejące testy są zbyt proste dla modeli i asystentów AI. Następnie Dan Hendrycks rozpoczął współpracę z firmą Scale AI w celu opracowania testu oraz pytań. Test ujrzał światło na początku 2025 roku.

Jak powstał “Ostateczny egzamin ludzkości”?

CAIS razem z Scale AI zebrali ponad 70 tysięcy pytań testowych, z których wybrali 13 tysięcy i przekazali je do specjalistów z różnych dziedzin na całym świecie. W sumie nad pytaniami pracował blisko tysiąc naukowców z 500 instytucji i 50 krajów na świecie. Co ciekawe autorzy pytań z TOP50 i TOP500, które trafiły finalnie do testu, zostali wynagrodzeni – odpowiednio 5000 i 500 dolarami.

Jakie pytania znajdują się w teście “Humanity's Last Exam”?

Wyobraź sobie test, w których wszystkie pytania są jak te za milion w “Milionerach” prowadzonych przez Huberta Urbańskiego. No dobra, nie są te same. Są trudniejsze i jest ich w sumie 2500.

W teście obecne są pytania z następujących dziedzin:

- Matematyka (41 proc.)

- Fizyka (9 proc.)

- Biologia i medycyna (11 proc.)

- Chemia (7 proc.)

- Nauki społeczne (9 proc.)

- Inżynieria (4 proc.)

- Technologie komputerowe i AI (10 proc.)

- Pozostałe (9 proc.)

14 procent pytań wymaga zrozumienia zarówno tekstu jak i przedstawionego obrazka. 24 procent ma więcej niż jedną poprawną odpowiedź. Większość wymaga, krótkiej, konkretnej odpowiedzi.

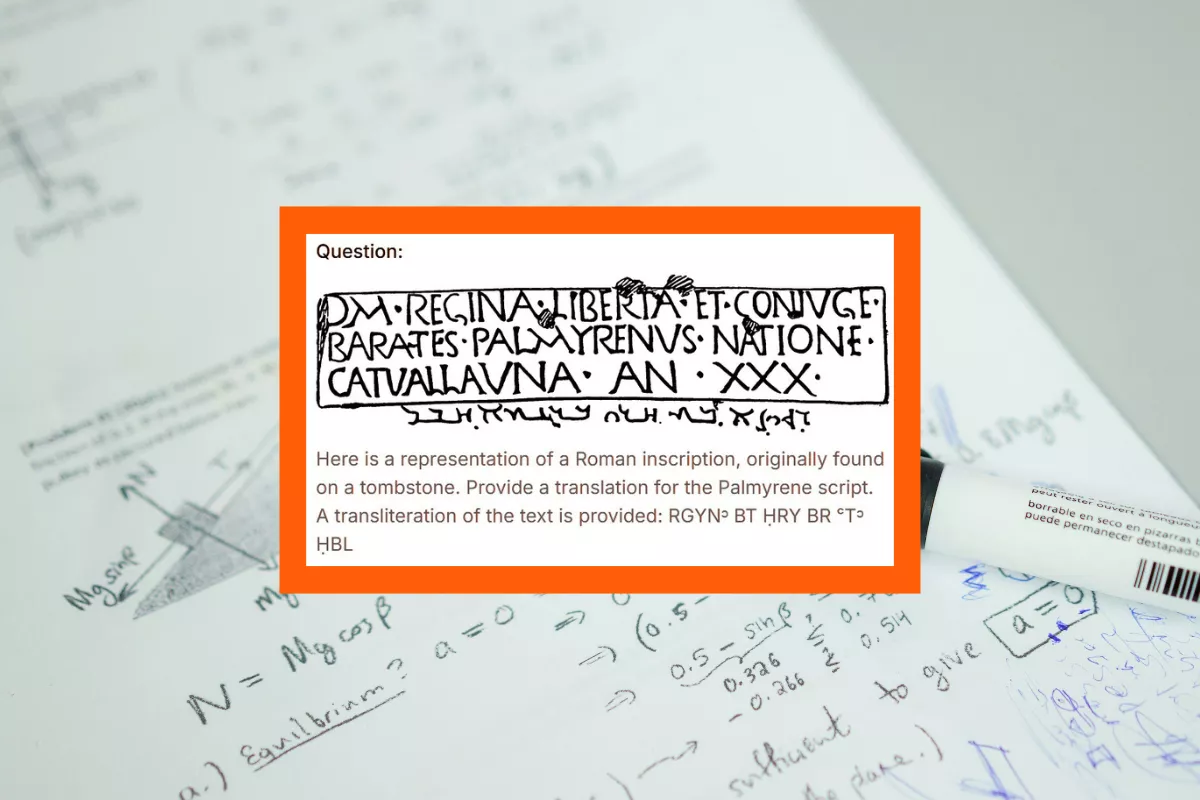

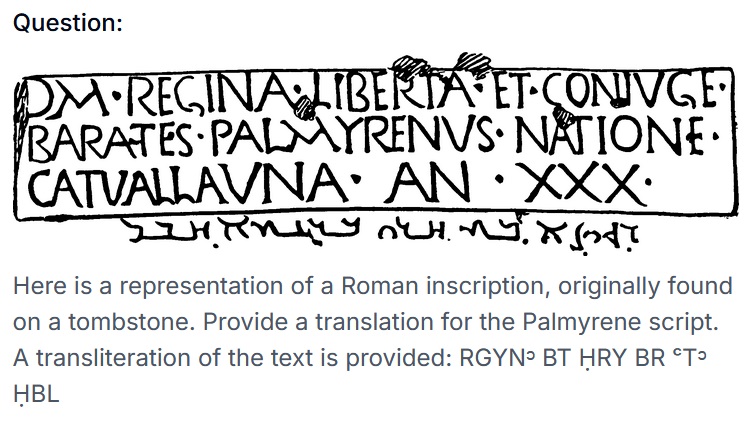

Twórcy testu ze zrozumiałych przyczyn, udostępnili na swojej stronie tylko dwa pytania z całego zestawu. Jedno z nich brzmi następująco:

“Kolibry z rodziny Apodiformes charakteryzują się tym, że posiadają dwustronnie parzystą kość owalną, trzeszczkę, osadzoną w ogonowo-bocznej części rozciągniętego rozcięgna krzyżowego przyczepu mięśnia obniżacza ogona. Ile parzystych ścięgien jest podtrzymywanych przez tę trzeszczkę? Odpowiedz, podając liczbę.”

Chciałbym zobaczyć minę Huberta Urbańskiego czytającego to pytanie. Pamiętaj, że słysząc je w “Milionerach” masz następnie cztery możliwe odpowiedzi do wyboru (telefon do przyjaciela raczej tu nie pomoże).

Drugie, udostępnione pytanie, sprawdza wspomniane wcześniej zrozumienie tekstu oraz grafiki. I również nie należy do najłatwiejszych, jeśli nie jest się specjalistą w danej dziedzinie.

Które AI osiągnęło najlepszy wynik w “Humanity's Last Exam”?

Ważna kwestia, na którą powinieneś zwrócić uwagę to fakt, która wersja danego asystenta AI była sprawdzana testem. Ich twórcy mają skłonność do podawania wyniku dla wersji “na sterydach”, czyli z dodatkowymi trybami czy narzędziami. Zazwyczaj są to wersje dostępne po opłaceniu wysokiej, miesięcznej subskrypcji. Darmowe odpowiedniki, z których korzysta większość osób osiągają sporo słabsze wyniki.

Ogłoszony na początku sierpnia GPT-5 w wersji PRO (płatny) osiągnął wynik 42 procent. Standardowy GPT-5 miał już sporo niższy wynik, bo 24,8 procent. Grok 4 zarówno w swojej rozszerzonej wersji Heavy jak i podstawowej osiągnął minimalnie lepsze rezultaty (44,4 i 25,4 procent). Wcześniejsze modele od różnych firm często mają problem z odpowiedzią na więcej niż 10 procent pytań. Jak widać postęp postępuje bardzo szybko.

To pokazuje trend, o którym się mówi od pewnego czasu – aby korzystać z pełni możliwości jakie daje AI należy płacić słone pieniądze. Miesięczne subskrypcje sięgają nawet 300 dolarów w przypadku Groka, co nawet na użytkownika z USA jest sporym wydatkiem.

Sam “Ostateczny egzamin ludzkości” nie jest zakończonym projektem, a raczej procesem, w którym chętni użytkownicy mogą sugerować zmiany lub znajdować błędy. Za każdy z nich twórcy płacą po 100 dolarów. Za pewien czas zapewne będziemy potrzebowali jeszcze bardziej ostatecznego testu, trudniejszego i uwzględniającego więcej aspektów rozumowania czy przetwarzania informacji.

Zobacz: Nowy trend na ChatGPT: Lustereczko powiedz przecie…

Newsletter

Newsletter

Sales&More i Bank Pekao S.A. wkraczają do gry! Sukces kampanii „Jak nie teraz, to kiedy… wbijesz na wyższy level?”

Sales&More i Bank Pekao S.A. wkraczają do gry! Sukces kampanii „Jak nie teraz, to kiedy… wbijesz na wyższy level?”  Serwisy społecznościowe, których już nie ma. Czego nas nauczyły?

Serwisy społecznościowe, których już nie ma. Czego nas nauczyły?  Będzie wielki powrót do „Szkła kontaktowego”?

Będzie wielki powrót do „Szkła kontaktowego”?  Filip Chajzer ponownie w „Dzień Dobry TVN”. Kolejne powroty na jubileusz programu

Filip Chajzer ponownie w „Dzień Dobry TVN”. Kolejne powroty na jubileusz programu

Dołącz do dyskusji: “Humanity's Last Exam”: test, który decyduje czyja AI jest najlepsza